GÉNESIS DIVINA

Explorando la Creación a través de la Astronomía y la Biología

Introducción

Los científicos que defienden la teoría de la evolución suelen considerar que el creacionismo carece de apoyo empírico y rigor científico. Sostienen que el creacionismo no debería incluirse en los planes de estudios de ciencias, ya que no ofrece una explicación científicamente fundamentada de la diversidad y complejidad de la vida en la Tierra.

Por otra parte, la teoría evolutiva contiene lagunas y preguntas sin respuesta, sobre todo en lo que respecta al origen de la vida y la complejidad de los sistemas biológicos. La selección natural y las mutaciones son insuficientes para explicar las intrincadas estructuras y funciones observadas en los organismos vivos. Además, la teoría evolutiva sólo se aplica a los organismos vivos existentes y no aborda el origen de la vida. Además, se basa en gran medida en suposiciones y reconstrucciones especulativas, lo que pone en entredicho su validez como explicación exhaustiva de la diversidad de la vida.

Este libro está escrito para explorar el debate entre creación y evolución mediante la discusión de la creación del universo, la singularidad de la Tierra y el origen de la vida.

En la primera parte, presentaremos la estructura jerárquica del universo y analizaremos la creación del universo tal y como revelan las observaciones astronómicas. A continuación, examinaremos si la creación del universo descrita en la Biblia concuerda con los hallazgos astronómicos, si la edad de la Tierra es de 6.000 años y analizaremos más detenidamente la naturaleza de ajuste fino del universo.

La segunda parte presenta diez hechos asombrosos sobre la Tierra, destacando su idoneidad única para albergar vida y señalando pruebas de un diseño intencionado.

En la tercera parte se explora el origen de la vida, cuestionando las teorías evolucionistas convencionales y destacando la complejidad de los sistemas biológicos como prueba de la creación divina. Se examina la idoneidad del término ‘teoría de la evolución de Darwin’ y se investiga si los seres humanos evolucionaron a partir de los simios. Además, se introduce el concepto de diseño inteligente y se explora el creacionismo a través de debates sobre la física de partículas, la existencia de vida extraterrestre, los instintos de los animales y las matemáticas que se encuentran en la naturaleza.

El libro concluye con una sentida invitación a la fe, animando a los lectores a reflexionar sobre su camino espiritual y a considerar el poder transformador de la fe. Presenta el Evangelio y ofrece orientación práctica sobre cómo abrazar la fe, incluidos los pasos para comprender y recibir la vida eterna, ofreciendo esperanza y seguridad a quienes buscan una conexión más profunda con Dios.

Espero que este libro proporcione un conocimiento renovado de la creación, profundizando en la comprensión del intrincado diseño y propósito entretejidos en el universo, y ofrezca la oportunidad de meditar en la gracia, la sabiduría y el poder ilimitados de Dios, el divino Creador, que sustenta todas las cosas y nos invita a maravillarnos ante Su obra.

Contenido

1. La creación del Universo

Puede que de niño recuerde noches de acampada en el campo o en lo alto de las montañas, contemplando las innumerables estrellas que brillan en la inmensidad de lo alto, o maravillándose con las estrellas fugaces que surcan graciosamente el cielo oscuro. Estas experiencias suelen llenarnos de asombro y admiración, de una profunda apreciación de la inmensa belleza y escala del universo. En esos momentos, es posible que hayas sentido una profunda conexión con el cosmos, acompañada de un sentimiento de humildad sobre el lugar que ocupas en él. Es posible que en tu mente se hayan agitado preguntas: ¿Cuántas estrellas llenan el cielo? ¿Podría haber vida más allá de nuestro mundo? ¿Cómo empezó el universo y cómo podría acabar? ¿Quién lo creó todo? La impresionante belleza y la enigmática naturaleza del cielo nocturno despiertan la curiosidad e invitan a reflexionar sobre los orígenes del universo y nuestro propósito en él. Estos momentos de fascinación dejan una huella perdurable, inspirándonos a buscar respuestas a los mayores misterios de la vida.

En este capítulo exploraremos el origen del universo desde las perspectivas astronómica y bíblica. Compararemos ambos puntos de vista para respaldar científicamente el relato de la creación del Génesis. Además, examinaremos qué fue creado primero, si la Tierra o el Sol, si la Tierra tiene 6.000 años de antigüedad y el concepto de un universo de ajuste fino.

a. La estructura jerárquica del Universo

Para discutir el origen del universo, exploremos primero su estructura jerárquica. Empezaremos por nuestro sistema solar y seguiremos con las galaxias, las galaxias externas, los cúmulos de galaxias, los supercúmulos y los complejos de supercúmulos.

i. El Sistema Solar

El sistema solar está formado por una estrella llamada Sol, ocho planetas que la orbitan, el cinturón de asteroides entre Marte y Júpiter, el Cinturón de Kuiper, y el miembro más exterior, la Nube de Oort. Una estrella se define como un cuerpo celeste autoluminoso alimentado por fusión nuclear, mientras que un planeta es un cuerpo celeste que refleja la luz de una estrella.

Fig. 1.1. Sistema solar incluyendo el Cinturón de Kuiper y la Nube de Oort

La Tierra es el tercer planeta desde el Sol. La distancia de la Tierra a la Luna es de 384.000 km, lo que llevaría 16 días en avión a 1.000 km/h. La distancia de la Tierra al Sol es de unos 150 millones de kilómetros, o una unidad astronómica (UA), lo que llevaría 17 años en avión. La distancia a Neptuno es de 30 UA, el Cinturón de Kuiper de 30 a 50 UA y la Nube de Oort de 2.000 a 200.000 UA. A la velocidad de la luz, se tardaría 8,3 minutos en viajar de la Tierra al Sol, 4 horas a Neptuno y 9,5 meses (0,79 años-luz) en alcanzar el borde interior de la Nube de Oort. En avión, tardaría unos 850.000 años.

Los cometas pueden clasificarse en cometas de corto y largo periodo. El Cinturón de Kuiper es la fuente de los cometas de periodo corto, y la Nube de Oort, la de los cometas de periodo largo. Debido a su origen, los cometas tienen órbitas muy elípticas con grandes excentricidades. El Sol tiene 109 veces el tamaño de la Tierra, 333.000 veces su masa y un periodo de rotación de unos 25 días.

ii. El sistema estelar

Al salir de la Nube de Oort, se entra en el reino de las estrellas. La estrella más cercana a la Tierra es Próxima Centauri, que tiene un 14% del tamaño del Sol, un 12% de su masa y se encuentra a unos 4,2 años luz. Viajar hasta allí en avión llevaría aproximadamente 4,6 millones de años.

Si observas de cerca las estrellas parpadeantes en el cielo nocturno, te darás cuenta de que tienen varios colores. El color de una estrella depende de la temperatura de su superficie: las estrellas más frías aparecen rojizas, mientras que las más calientes son blanquecinas. Por ejemplo, Betelgeuse (α Ori) es roja, el Sol es amarillo y Sirio (α CMa), la estrella más brillante del cielo nocturno, es blanca azulada.

La masa de una estrella determina su tasa de fusión nuclear, que a su vez rige su luminosidad y su vida útil. Las estrellas más masivas consumen su combustible más rápidamente que las menos masivas. Las estrellas terminan su vida como enanas blancas, estrellas de neutrones o agujeros negros. Las estrellas con un núcleo de masa inferior a 1,4 masas solares se convierten en enanas blancas, las que tienen un núcleo de masa comprendida entre 1,4 y 3 masas solares se convierten en estrellas de neutrones y explotan como supernovas, y las que tienen un núcleo de masa superior a 3 masas solares se convierten en agujeros negros tras pasar por la fase de estrella de neutrones. Los restos de las explosiones de supernova pueden reciclarse para formar nuevas estrellas.

Fig. 1.2. Las estrellas presentan una gran variedad de colores

Normalmente, menos de un centenar de estrellas son visibles a simple vista en una ciudad, y unas mil en el campo en condiciones ideales. La mayoría de estas estrellas se encuentran a menos de 50 años luz de la Tierra.

iii. Nuestra Galaxia (Vía Láctea)

La Vía Láctea es una galaxia espiral barrada que contiene entre 200.000 y 400.000 millones de estrellas, además de grandes cantidades de gas, polvo y materia oscura. Su diámetro es de unos 100.000 años-luz y su grosor de unos 1.000 años-luz, lo que la convierte en una estructura relativamente plana en forma de disco con una protuberancia central.

El Sol está situado a unos 26.000 años-luz del centro galáctico, orbitándolo una vez cada 220 millones de años, período conocido como año galáctico. Nuestro sistema solar reside cerca del Espolón de Orión, un brazo menor situado entre los brazos espirales de Sagitario y Perseo. Situado a unos 60 años-luz por encima del plano galáctico, este emplazamiento ofrece una perspectiva ventajosa para observar el universo en múltiples direcciones con la mínima obstrucción del denso polvo y gas del disco galáctico.

Fig. 1.3. Nuestra galaxia (Vía Láctea)

iv. Galaxias, cúmulos de galaxias y supercúmulos

La Galaxia de Andrómeda (M31) es la más cercana a la Vía Láctea, situada en a unos 2,5 millones de años-luz de la Tierra. Es visible a simple vista desde el hemisferio norte (magnitud visual = 3,4) y tiene una forma similar a la de la Vía Láctea. La galaxia de Andrómeda se aproxima a la Vía Láctea a una velocidad de unos 110 km/s y se espera que colisione con ella dentro de unos 4.000 millones de años.

Las galaxias pueden clasificarse en tres grandes categorías morfológicas: espirales, elípticas e irregulares. Cuando dos galaxias espirales colisionan, sus interacciones gravitatorias pueden provocar una transformación drástica, que a menudo da lugar a la formación de una galaxia elíptica. Este proceso suele desarrollarse a través de etapas en las que interactúan galaxias, seguidas de una fase de galaxia infrarroja luminosa (LIRG) o galaxia infrarroja ultraluminosa (ULIRG).

Fig. 1.4. Galaxia espiral, galaxia elíptica y galaxia irregular

Si menos de 50 galaxias están unidas gravitatoriamente, se denominan ‘grupo de galaxias’, y si lo están cientos o miles, se llaman ‘cúmulos de galaxias’. Más de 40 galaxias cercanas, entre ellas la Vía Láctea y Andrómeda, pertenecen al Grupo Local. El Grupo Local y el Cúmulo de Virgo forman parte del Supercúmulo de Virgo, que a su vez forma parte del Supercúmulo de Laniakea.

Un complejo de supercúmulos, también conocido como filamento galáctico o cadena de supercúmulos, es una inmensa estructura a gran escala en el universo, compuesta por numerosos supercúmulos de galaxias que están interconectados por vastas redes de galaxias, gas y materia oscura. Estas regiones interconectadas forman un patrón similar a una telaraña y representan las estructuras más grandes que se conocen en el cosmos. Abarcan distancias increíbles, desde cientos de millones hasta miles de millones de años luz, empequeñeciendo estructuras cósmicas más pequeñas. Entre ellas, la Gran Muralla Hércules-Corona Borealis destaca como el mayor complejo de supercúmulos conocido, un testimonio sobrecogedor de la escala del universo. Se calcula que en el universo observable hay unos 200.000 millones de galaxias, repartidas a lo largo de una asombrosa distancia de aproximadamente 93.000 millones de años luz, cada una de las cuales contribuye a el intrincado tapiz de estructuras cósmicas.

Fig. 1.5. Supercúmulos cercanos (amarillo: supercúmulo Laniakea)

b. Creación del Universo

¿Cómo empezó el universo? ¿Ha existido siempre, o fue creado por Dios? Para explorar este tema, examinaremos el origen del universo tal como se observa en astronomía y como se describe en el Libro del Génesis de la Biblia.

i. Creación del Universo en Astronomía

La teoría más extendida sobre el origen del universo es la del Big Bang, que postula que el universo comenzó hace aproximadamente 13.800 millones de años como un punto increíblemente caliente y denso que se expandió rápidamente. Esto plantea naturalmente la intrigante pregunta: ‘¿Qué existía antes del Big Bang?’ Una de las principales hipótesis afirma, con creciente apoyo en, que antes del Big Bang el universo existía en un estado de fluctuaciones cuánticas dentro del vacío, una base dinámica y probabilística de la que surgió nuestro universo.

Antes de Paul Dirac, el vacío se consideraba un espacio vacío sin nada. En 1928, Dirac combinó la mecánica cuántica y la relatividad especial para describir el comportamiento de un electrón a velocidades relativistas. Curiosamente, la ecuación sugería dos soluciones para el electrón: una para un electrón con energía positiva y otra para un electrón con energía negativa. Dirac propuso que el vacío no es un espacio vacío, sino que está lleno de un número infinito de electrones con energía negativa (positrón). Por ello, el vacío recibe a veces el nombre de Mar de Dirac.

Aunque el Mar de Dirac parece estático, nunca lo es debido al principio de incertidumbre de Heisenberg. Los pares de partículas y antipartículas aparecen espontáneamente (producción de pares) y desaparecen (aniquilación de pares) de forma aleatoria. La escala temporal es de 10-21 segundos e invisible para el ojo humano, pero si hay una cámara que pueda captarlo, será como mirar un mar fluctuante. Es lo que se llama ‘fluctuación cuántica’. El Big Bang surgió del mar de la fluctuación cuántica en un punto singular. El Big Bang en sí es el principio del universo.

Fig. 1.6. Modelo 3D de fluctuaciones cuánticas en el vacío

Inmediatamente después del Big Bang, el universo sufrió rápidos cambios debido a su temperatura y densidad extremadamente altas. De 10-43 segundos (tiempo de Planck) a 10-36 segundos, el universo se rigió por la Teoría de la Gran Unificación, en la que se unifican las tres fuerzas (fuerte, débil y electromagnética) del Modelo Estándar. El universo pasó por una época inflacionaria de 10-36 segundos a 10-32 segundos, una época electrodébil de 10-32 segundos a 10-12 segundos, una época de los quarks de 10-12 segundos a 10-6 segundos, una época hadrónica de 10-6 segundos a 1 segundo y una época leptónica de 1 segundo a 10 segundos.

Al final de la época leptónica se produjo un acontecimiento dramático y crucial. Los pares de leptones y antileptones, formados principalmente por electrones y positrones, se aniquilaron mutuamente. Este proceso liberó un inmenso número de fotones (partículas de luz), inundando el universo de luz. Estos fotones se convirtieron en la forma de energía dominante en el cosmos, marcando el comienzo de lo que se conoce como la época de los fotones. Esta época, que duró desde unos 10 segundos hasta 380.000 años después del Big Bang, se caracterizó por un plasma caliente y denso de electrones, núcleos y fotones libres. Durante esta época, los fotones eran dispersados por electrones y protones libres, lo que les impedía viajar libremente y hacía que el universo fuera opaco.

La época de recombinación siguió al final de la época de los fotones, en la que se produjo otro acontecimiento importante. Los electrones se combinan con protones para formar hidrógeno neutro y helio. Este es el comienzo de la era dominada por la materia. Cuando esto ocurrió, el universo lleno de plasma se volvió gradualmente transparente y se transformó en el espacio que podemos llamar cielo. Cuando esto ocurre, los fotones producidos durante la época de los fotones, pero previamente confinados por el plasma, pueden ahora moverse libremente por el universo transparente. Estos fotones que se mueven libremente se observan como luz muy brillante y forman la radiación cósmica de fondo de microondas.

Las estrellas y galaxias que vemos hoy se formaron a partir de los átomos creados durante la época de recombinación. Desde entonces, el universo ha seguido expandiéndose como consecuencia del Big Bang. Cuando el universo tenía 9.800 millones de años, la energía oscura comenzó a dominar, marcando el inicio de la era dominada por la energía oscura. En esta era, el universo continúa expandiéndose a un ritmo acelerado. Esta expansión acelerada es el estado actual del universo.

ii. El destino del Universo (¿Otra vez el Big Bang?)

El destino del universo depende de su densidad global. Según las mediciones del WMAP, la densidad actual del universo es aproximadamente igual a la densidad crítica (unos 10-29 g cm-3) con un margen de error del 0,5%. Sin embargo, esta incertidumbre significa que aún no podemos determinar definitivamente el destino final del universo hasta que se obtengan mediciones más precisas. Si la densidad del universo es superior a la densidad crítica, las fuerzas gravitatorias acabarán por superar la expansión, provocando el colapso del universo sobre sí mismo en un acontecimiento catastrófico conocido como Big Crunch, característico de un universo cerrado.

Por el contrario, si la densidad es inferior a la densidad crítica, el universo seguirá expandiéndose eternamente a un ritmo acelerado, lo que llevaría a un escenario conocido como Big Rip, característico de un universo abierto. En este caso, la temperatura del universo se enfriará progresivamente a medida que avance la expansión, y la formación de estrellas acabará por cesar debido al agotamiento del medio interestelar necesario para la creación estelar. Con el tiempo, el universo se volverá cada vez más oscuro y frío, un proceso a menudo denominado ‘muerte por calor’.

Las estrellas existentes se quedarán sin combustible y dejarán de brillar. Posteriormente, se producirá la desintegración de protones, tal como predice la Gran Teoría Unificada, cuando la edad del universo sea de unos 1032 años. Alrededor de 1043 años, los agujeros negros comenzarán a evaporarse a través de la radiación Hawking. Después de que todas las materias bariónicas hayan decaído y todos los agujeros negros se hayan evaporado, el universo se llenará de radiación. La temperatura del universo se enfriará hasta el cero absoluto y todo estará oscuro y vacío, lo que se asemeja al estado del universo sometido a fluctuaciones cuánticas antes del Big Bang.

Fig. 1.7. Destino del universo y agujero negro en evaporación

Recientemente se han descubierto dos megaestructuras cósmicas a 7.000 millones de años luz de la Tierra, en dirección a la Osa Mayor. El Arco Gigante, descubierto en 2022, y el Gran Anillo, descubierto en 2024, desafían el principio cosmológico que afirma que el universo es homogéneo e isótropo a gran escala. Estas megaestructuras requieren una explicación adecuada. Una posible explicación es que sean enormes cuerdas cósmicas o restos de la evaporación Hawking de agujeros negros supermasivos (puntos Hawking) del Big Bang anterior.

Esta interpretación está relacionada con la Cosmología Cíclica Conforme (CCC) de Roger Penrose. La CCC es un modelo cosmológico basado en la relatividad general, en el que el universo se expande eternamente hasta que toda la materia decae y abandona los agujeros negros. En la CCC, el universo itera a través de ciclos infinitos, con un nuevo Big Bang emergiendo dentro del Big Bang actual en constante expansion.

Fig. 1.8. Gran Anillo (azul) y Gran Arco (rojo)

Personalmente, encuentro atractivo el CCC porque ofrece soluciones potenciales a algunos problemas de la evolución de las galaxias. Existe una correlación entre la masa de un agujero negro y la dispersión de la velocidad estelar (la relación M-sigma). Según esta relación, la masa de un agujero negro es aproximadamente el 0,1% de la masa de su galaxia. Recientemente, Chandra y JWST descubrieron una galaxia intrigante, UHZ1, a través de lentes gravitacionales. UHZ1 se encuentra a una distancia de 13.200 millones de años-luz, observada cuando nuestro universo tenía sólo un 3% de su edad actual. La masa estimada del agujero negro de UHZ1 resultó ser mayor que la de la galaxia que lo alberga. Esta gran masa del agujero negro no puede explicarse con las teorías actuales sobre la masa de los agujeros negros, pero sí con la CCC. Esto puede entenderse si el agujero negro de UHZ1 era un agujero negro reciclado del Big Bang anterior y se convirtió en un agujero negro semilla en UHZ1 durante el Big Bang actual

No sabemos cómo se produce el nuevo Big Bang mientras el Big Bang actual sigue expandiéndose. Podríamos intentar utilizar el concepto de hiperespacio. En este escenario, el universo se expande en un espacio tridimensional. Sin embargo, imaginemos nuestro universo tridimensional como una superficie incrustada en un espacio de mayor dimensión (hiperespacio). Este espacio de mayor dimensión podría ser un espacio de cuatro dimensiones (o más) donde todo nuestro universo es sólo una ‘rebanada’ o una ‘brana’.

A medida que nuestro universo siga expandiéndose, podría llegar a converger en un punto singular de este hiperespacio de dimensiones superiores, de forma muy parecida a como una superficie bidimensional puede curvarse y converger en un punto del espacio tridimensional. Este punto del hiperespacio podría ser análogo al cuello de una botella de Klein, una forma de dimensión superior en la que la superficie hace un bucle sobre sí misma.

Cuando la expansión del universo en el espacio tridimensional converja hacia este punto singular en el hiperespacio, podrían crearse condiciones en las que la densidad de energía se vuelva extremadamente alta. Si este punto singular en el hiperespacio no puede acomodar la inmensa afluencia de energía y energía del vacío del universo en expansión actual, podría producirse una explosión. Esta explosión sería el comienzo de un nuevo Big Bang, que crearía un nuevo universo.

De este modo, el universo actual del Big Bang, en constante expansión, podría conducir a la formación de un nuevo universo en el marco del hiperespacio, con la convergencia a un punto singular que actuaría como puente entre los ciclos del CCC. Esta convergencia de dimensiones superiores proporciona un mecanismo para los ciclos continuos del Big Bang mientras el universo actual sigue expandiéndose, y la energía de este universo en expansión también podría contribuir a la energía oscura que impulsa su aceleración.

Fig. 1.9. Cosmología cíclica conforme

iii. La Creación del Universo en la Biblia

En esta sección analizaré la creación del universo tal como se describe en la Biblia desde una perspectiva astronómica, examinando cómo podría alinearse el relato bíblico con la comprensión científica moderna. Este análisis ahondará en los posibles paralelismos entre el relato bíblico y las observaciones astronómicas. Aunque este enfoque ofrece una perspectiva interesante, es importante reconocer que hay otras formas de interpretar el relato bíblico de la creación. Estas interpretaciones pueden variar en función de los contextos teológico, filosófico y cultural, y cada una de ellas aporta una visión única de la profunda narración de los orígenes del universo.

a) Dios declaró la creación del universo

La creación del universo se describe en el Génesis, el primer libro de la Biblia.

“En el principio creó Dios los cielos y la tierra.” (Génesis 1:1)

Este versículo introduce el acto de la creación por Dios, afirmando que Él es el iniciador de todo lo que existe. La frase “los cielos y la tierra” abarca toda la creación, indicando la totalidad del universo.

“Y la tierra estaba desordenada y vacía, y las tinieblas estaban sobre la faz del abismo, y el Espíritu de Dios se movía sobre la faz de las aguas.” (Génesis 1:2)

El término “tierra” representa aquí la creación física, material (es decir, la materia bariónica) a la que Dios daría forma más tarde. La frase “la tierra estaba desordenada” puede interpretarse como la descripción de un estado primordial de vacío, en el que aún no se había creado nada. El término “vacía” significa un espacio vacío, y si no hay nada dentro de ese espacio, puede llamarse legítimamente vacío. Por lo tanto, la frase “la tierra estaba desordenada y vacía” sugiere que, desde el principio, el universo existía como un vacío, un estado inicial de nada. La siguiente frase “las tinieblas estaban sobre la faz del abismo” tiene un significado profundo. La “tinieblas” es חֹשֶׁך (choshek) en hebreo y significa literalmente oscuridad total sin ninguna luz. Lo “abismo” es תְּהוֹם (tehom) en hebreo y se derivó de הום (hom) que significa 'alboroto' o 'fluctuar'. Por lo tanto, “Y la tierra estaba desordenada y vacía, y las tinieblas estaban sobre la faz del abismo” puede interpretarse como una descripción del origen del universo a partir de un vacío en un estado de oscuridad y fluctuación. Esta interpretación concuerda estrechamente con la condición del universo en su etapa más temprana, justo antes del Big Bang, cuando existía como un vacío sometido a fluctuaciones cuánticas.

b) La creación de la luz

El acontecimiento principal del primer día de la creación es la creación de la luz.

“Y dijo Dios: Sea la luz; y fue la luz.” (Génesis 1:3)

El versículo afirma que Dios inició la creación del universo creando la luz. De manera similar, el Big Bang comenzó con una serie de épocas rápidas, que en conjunto duraron menos de un segundo, y que finalmente condujeron a la creación de la luz (fotones) durante la época de los fotones. La creación de la luz en Génesis 1:3 se corresponde de manera notable con la creación de la luz durante la era de los fotones, lo que alinea poderosamente el relato bíblico con este momento crucial en los inicios del universo.

c) La creación del cielo

El acontecimiento principal del segundo día de la creación es la creación del cielo.

“E hizo Dios la expansion, y..., Y llamó Dios a la expansión Cielos...”. (Génesis 1:7, 8)

La creación del cielo descrita en el Génesis puede correlacionarse con la época de recombinación de la cosmología del Big Bang. Antes de esta época, el universo era opaco, lleno de un plasma denso y caliente de electrones, neutrones, protones y fotones. Este plasma dispersaba los fotones, impidiéndoles viajar libremente y haciendo que el universo fuera opaco a la radiación. Durante esta época, el universo tenía unos 10 años-luz de diámetro, lo que significaba que no había espacio despejado para un ‘cielo’ visible.

Sin embargo, en la época de recombinación, el universo se enfrió lo suficiente como para que electrones y protones se combinaran y formaran átomos neutros de hidrógeno. Este proceso limpió el plasma, haciendo el universo transparente y permitiendo que los fotones viajaran libremente por el espacio. Como resultado, surgió una vasta extensión transparente, lo que conocemos como el cielo visible, con un radio de unos 42 millones de años-luz. Por lo tanto, la creación del cielo en Génesis 1:7-8 puede interpretarse como una referencia a este acontecimiento crucial en la historia cósmica.

La siguiente tabla resume la creación del universo tal y como se describe en la Biblia y como la explica la astronomía. La comparación muestra que el relato de la creación en el Génesis concuerda con los hechos astronómicos en un grado notable, lo que confirma que Dios ya había revelado estas verdades a través de la Biblia mucho antes de que fueran descubiertas por la ciencia.

Génesis | Astronomía |

Fluctuación del vacío (Gn 1:2 - antes de la Creación) | Fluctuación del vacío (antes del Big Bang) |

Creación de luz (Gn 1:3 - Día 1 de la Creación) | Creación de luz (Época fotónica) |

Creación del cielo (Gn 1:7-8 - Día 2 de la Creación) | Creación del cielo (Época de recombinación) |

Tab. 1.1. Comparación de la Creación en el Génesis y la Astronomía

c. ¿Qué se creó primero, la Tierra o el Sol?

El acontecimiento principal del tercer día de la creación en el Génesis es la creación de la tierra seca y el mar. Puede entenderse como el periodo durante el cual se formó y estructuró la Tierra. El proceso de acumulación de agua y revelación de la tierra seca significa el desarrollo de la superficie terrestre y de los accidentes geográficos. El acontecimiento principal del cuarto día del Génesis es la creación del Sol. Así pues, la Tierra fue creada antes que el Sol. Será interesante examinar si el relato bíblico es coherente con las observaciones astronómicas. Explorémoslo.

Las estrellas y los planetas se forman a partir de nubes moleculares. Las nubes moleculares están formadas por un 98% de gas (un 70% de hidrógeno y un 28% de helio) y un 2% de polvo (carbono, nitrógeno, oxígeno, hierro, etc.). La mayoría de las estrellas y los planetas jovianos están formados por gas, y la mayoría de los planetas terrestres, por polvo. Las protoestrellas se forman cuando las nubes moleculares colapsan bajo su propia gravedad. Durante este proceso, el material restante de las nubes moleculares forma un disco giratorio conocido como disco protoplanetario, que es la región donde los planetas acaban tomando forma. El colapso gravitatorio inicia el calentamiento y la compresión del núcleo, dando lugar al nacimiento de una protoestrella, mientras que el disco giratorio circundante proporciona el entorno para la formación y evolución de los cuerpos planetarios.

Fig. 1.10. Protoestrella y disco protoplanetario, y diagrama H-R

A medida que la protoestrella continúa contrayéndose, se convierte en una estrella de la pre-secuencia principal y sigue las vías de evolución estelar conocidas como la vía de Hayashi (para estrellas de baja masa) y la vía de Henyey (para estrellas de alta masa) en el diagrama de Hertzsprung-Russell (diagrama H-R). Las estrellas de la pre-secuencia principal pueden observarse como estrellas T Tauri si su masa es inferior a 2 masas solares, y como estrellas Herbig Ae/Be si su masa es superior a 2 masas solares. La de la pre-secuencia principal continúa contrayéndose hasta que su temperatura interna aumenta de 10 a 20 millones de grados. En este punto, la estrella de pre-secuencia principal estrella comienza la fusión nuclear del hidrógeno y se convierte en una verdadera estrella en el cielo. Las estrellas que se encuentran en esta fase se denominan estrellas de secuencia principal.

Según la teoría de la evolución estelar y los estudios de heliosismología, el Sol permaneció en la etapa previa a la secuencia principal entre 40 y 50 millones de años, tras lo cual se convirtió en una estrella de secuencia principal.

Mientras la estrella se forma en el centro, los planetas se forman en el disco protoplanetario. Las colisiones de partículas de polvo y gas forman guijarros, los guijarros se convierten en rocas y las rocas en planetesimales. Estos planetesimales son los componentes básicos de los planetas

Sólo recientemente se han estudiado activamente los detalles del proceso de formación de planetas en el disco protoplanetario. Los estudios predicen que se tardarán unos pocos millones de años en formar un planeta del tamaño de la Tierra a partir de guijarros de 1 mm de tamaño. Esta predicción puede comprobarse con observaciones reales, como las imágenes submilimétricas de ALMA de las estrellas T Tauri HL Tau y PDS 70.

La masa de HL Tau es de aproximadamente dos masas solares y su edad ronda el millón de años. La imagen revela que ya se han formado varios planetas que orbitan alrededor de la estrella central de la secuencia preprincipal, como indican los huecos en el disco protoplanetario. La masa de PDS 70 es de aproximadamente 0,76 masas solares y su edad es de unos 5,4 millones de años. Dos exoplanetas, PDS 70b y PDS 70c, han sido observados directamente por el VLT de ESO. En 2023, las observaciones espectroscópicas del telescopio espacial James Webb detectaron agua en la región de formación de planetas terrestres del disco protoplanetario y sugirieron que en su interior se han formado dos o más planetas terrestres. Es importante señalar que las nubes de gas y polvo observadas en HL Tau se eliminaron en gran medida en PDS 70, y en el centro se han formado planetas terrestres que contienen agua.

Los planetas terrestres tardaron 5,4 millones de años en formarse, pero aunque tardaran 10 millones de años, seguirían siendo muchos menos que los 40 a 50 millones de años que tardó el Sol en convertirse en una estrella de la secuencia principal. Esto sugiere que la Tierra fue creada antes que el Sol, como se afirma en el Génesis, y es coherente con las observaciones astronómicas.

Fig. 1.11. HL Tau y PDS 70

Otro acontecimiento importante que Dios realizó en el tercer día fue la creación de plantas y árboles. Los ateos y evolucionistas se preguntan a menudo cómo pudieron sobrevivir estas plantas y árboles si el Sol fue creado en el cuarto día. Esta pregunta puede abordarse en el contexto de la teoría de la evolución estelar. Cuando se formó la Tierra, el Sol aún se encontraba en la fase de estrella T Tauri. Aunque las estrellas T Tauri no son estrellas de la secuencia principal, su temperatura superficial oscila entre 4.000 y 5.000 Kelvin. La radiación de cuerpo negro a esta temperatura alcanza su punto máximo en la longitud de onda visible. Además, el tamaño del Sol cuando era una estrella T Tauri era varias veces mayor que su tamaño actual. Por lo tanto, podría proporcionar suficiente energía en el rango de longitud de onda visible para permitir la fotosíntesis en plantas y árboles.

d. ¿Tiene la Tierra 6.000 años?

El ' creacionismo de la Tierra joven ' es la creencia de que la Tierra y el universo son relativamente jóvenes, normalmente de unos 6.000 a 10.000 años de antigüedad, basada en una interpretación literal del relato bíblico de la creación en el Génesis. Los creacionistas de la Tierra joven creen que la Tierra se creó en seis días de 24- horas y rechazan gran parte del consenso científico moderno sobre la edad de la Tierra y el universo. Numerosas pruebas científicas procedentes de diversos campos, como la geología, la astronomía y la física, indican que la Tierra tiene aproximadamente 4.600 millones de años y el universo unos 13.800 millones de años. A pesar de estas abundantes pruebas, los creacionistas de la Tierra joven no están de acuerdo. Esta situación recuerda al debate entre los modelos geocéntrico y heliocéntrico en tiempos de Galileo Galilei.

Antes de entrar en el debate principal, veamos algunos ejemplos que facilitan la comprensión de que la Tierra y el universo tienen al menos varios millones de años.

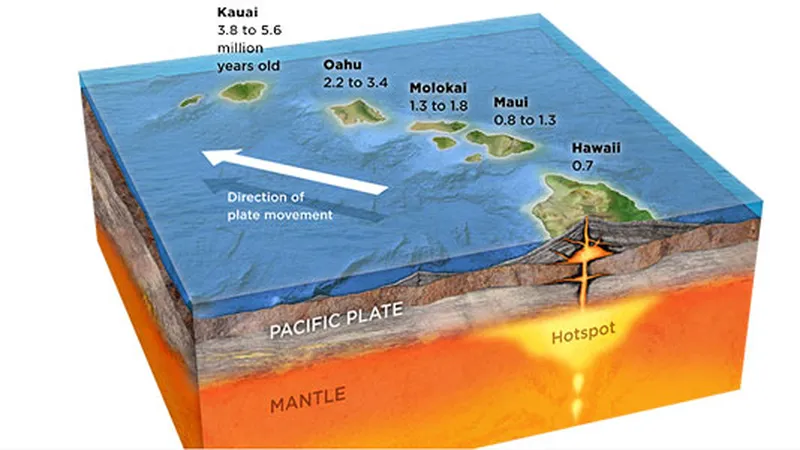

La corteza terrestre está formada por placas tectónicas que se mueven lentamente, provocando terremotos. Nadie negaría este hecho. Un punto caliente es un punto en el que el magma fluye desde las profundidades del manto bajo la corteza, con su centro fijo. Cuando el magma fluye hacia la corteza y se enfría, forma tierra. Las islas hawaianas son un buen ejemplo de este proceso. En la Gran Isla de Hawai, el Kilauea sigue siendo un volcán activo, y a medida que el magma que erupciona se enfría en el agua del mar, se forma nueva tierra. La tierra recién formada se desplaza hacia el noroeste a un ritmo de unos 7-10 cm al año debido a la tectónica de placas, y este proceso ha creado las distintas islas de Hawai. Esto sucede incluso ahora, y es un hecho innegable.

Fig. 1.12. Historia geológica de las islas hawaianas

Teniendo en cuenta la velocidad a la que se mueven las placas tectónicas, las edades de las islas hawaianas se estiman así: la Isla Grande tiene 400.000 años, Maui 1 millón de años, Molokai 1,5-2 millones de años, Oahu (donde está Waikiki) 3-4 millones de años y Kauai unos 5 millones de años. En la Gran Isla, se puede ver que gran parte de la tierra sigue cubierta de suelo volcánico negro, lo que indica una meteorización mínima. En cambio, Kauai ha sufrido una importante meteorización, lo que ha permitido que florezca la vegetación, lo que le ha valido el sobrenombre de ‘La Isla Jardín’. Este ejemplo proporciona pruebas directas de que la Tierra tiene al menos varios millones de años.

Para comprender directamente que el universo tiene al menos varios millones de años, basta con aceptar que la luz viaja a 300.000 km por segundo. El Sol está a 150 millones de km de la Tierra. Por tanto, la luz solar que recibimos ahora se generó en el Sol hace 8,3 minutos. El Sol es unas 400 veces más grande que la Luna, pero como está mucho más lejos, en el cielo parece tener aproximadamente el mismo tamaño que la Luna. Nadie lo negaría. La galaxia de Andrómeda tiene un tamaño similar al de nuestra Vía Láctea, pero se encuentra a 2,5 millones de años luz, lo que la hace parecer unas cuatro veces mayor que la Luna. El hecho de que podamos ver la Galaxia de Andrómeda significa que la luz que observamos se creó en Andrómeda hace 2,5 millones de años y acaba de llegar hasta nosotros. Si has visto la Galaxia de Andrómeda, no puedes negar este hecho. Se trata de una prueba directa de que el universo tiene al menos varios millones de años.

A pesar de estos hechos, si se sigue insistiendo en que la Tierra tiene 6.000 años, podría convertirse en un escollo más que en una ayuda para difundir el Evangelio, lo que podría distanciar a muchas personas de él. Por tanto, en lugar de defender el creacionismo de la Tierra joven, sería más razonable leer detenidamente el Génesis en la Biblia y tratar de encontrar una solución.

Para los humanos, el tiempo siempre fluye del presente al futuro y nunca fluye hacia atrás. Definimos un día como 24 horas, pero si fuéramos creados en otros planetas, un día no tendría 24 horas. Por ejemplo, si fuéramos creados en Venus, un día serían 243 días terrestres, y en Júpiter, un día serían 10 horas terrestres. Por lo tanto, a menos que cambiemos nuestra definición y percepción del tiempo desde una perspectiva geocéntrica, será difícil abordar esta cuestión. Discutámoslo más a fondo teniendo en cuenta estos hechos.

i. Los días en el Génesis

En primer lugar, estimemos la edad del universo basándonos en los registros del Génesis. Según el Génesis, Dios creó el universo y todo lo que hay en él en seis días. El tiempo transcurrido desde Adán hasta Noé puede estimarse utilizando los registros genealógicos de Génesis 5:3-32. El diluvio de Noé ocurrió cuando Noé tenía 600 años, y el número total de años desde Adán hasta el diluvio es de 1.656 años. No sabemos cuándo ocurrió el diluvio de Noé. Algunos eruditos y tradiciones bíblicas intentan datar el diluvio utilizando genealogías en la Biblia, estimando que ocurrió alrededor de 2300-2400 a.C.. Por tanto, la edad del universo, según esta interpretación, es de 7 días + 1.656 años + 4.400 años = 6.056 años. Esta es la base teórica de la afirmación de los creacionistas de que la Tierra tiene 6.000 años.

Para abordar el problema de la edad diurna, echemos otro vistazo al Génesis. Aunque no parece haber problemas con los registros genealógicos del Génesis, puede existir cierto debate sobre el año exacto del diluvio de Noé. Sin embargo, que el diluvio de Noé ocurriera hace 4.400 o 44.000 años no afecta significativamente a la edad del universo, tal como se entiende en el contexto científico de 13.800 millones de años. Entonces, ¿dónde está la clave para resolver el problema de la edad diurna? Quizá ya se haya dado cuenta: la clave está en la interpretación de los siete primeros días de la creación.

Fig. 1.13. Para definir un día, la Tierra y el Sol deben existir de antemano.

La razón es sencilla: un día se define como el periodo de rotación del planeta en el que vivimos. Para definir un día, tanto el Sol como la Tierra deben existir de antemano. Sin embargo, en Génesis se dice que la Tierra fue creada al tercer día y el Sol al cuarto, pero Dios utilizó los términos ‘día’ y ‘noche’ incluso antes de su creación. Esto implica que el ‘día’ en Génesis no es el día de 24 horas como lo definimos nosotros, sino un ‘día’ como lo definió Dios. La falacia de los creacionistas de la Tierra joven radica en su malentendido de que el ‘día’ mencionado en el Génesis se refiere a un día humano literal de 24 horas, lo que lleva a una interpretación errónea del término ‘día’ en el relato del Génesis.

Si los días del Génesis no son los periodos de 24 horas definidos por los humanos, cabe preguntarse: ‘¿Cuánto duran los días del Génesis en términos de días humanos?’. Aunque no conocemos la respuesta exacta, podemos estimar un periodo aproximado comparando los acontecimientos de la creación descritos en el Génesis con los del Big Bang.

El acontecimiento principal del primer día de la creación es la creación de la luz. La época de los fotones en el Big Bang corresponde a este acontecimiento, y el tiempo humano del primer día es de 380.000 años. El acontecimiento principal del segundo día de la creación es la creación del cielo. La época de recombinación corresponde a este acontecimiento, siendo el tiempo humano del segundo día de 100.000 años. El acontecimiento principal del tercer día es la creación de la Tierra. Como vimos en la sección anterior, la Tierra tarda unos 10 millones de años en formarse, por lo que el tercer día de la creación habría durado más de 10 millones de años. De igual manera, el evento principal del cuarto día es la creación del Sol. Dado que el Sol tarda aproximadamente entre 40 y 50 millones de años en formarse, el cuarto día de la creación habría durado más de 40 millones de años. La siguiente tabla resume los resultados anteriores.

Aquí observamos algunos hechos inesperados sobre el concepto de tiempo utilizado por Dios. Los días del relato de la creación son mucho más largos que un día humano de 24 horas. Además, el tiempo de Dios no es fijo, sino variable, desde cientos de miles de años hasta más de 40 millones de años. ¿Cómo podemos entender esto? En cierto sentido, no es un resultado sorprendente, sino esperado.

Día de la Creación | Acontecimiento en el Génesis | Evento en Astronomía | Humano tiempo |

Día 1 | Creación de la luz | Creación de la luz en la época de los fotones | 380.000 años |

Día 2 | Creación del cielo | Creación del cielo en la época de recombinación | 100.000 años |

Día 3 | Creación de la Tierra | Creación de la Tierra | > 10 millones de años |

Día 4 | Creación del Sol | Creación del Sol | > 40 millones de años |

Tab. 1.2. Días de Creación en Tiempo Humano

ii. El Creador del Tiempo

El ‘día’ utilizado en el Génesis es yom (יום) en hebreo. Yom puede interpretarse de varias maneras, entre ellas una que se refiere a la edad o a un largo periodo de tiempo. Esta interpretación sugiere que cada ‘día’ de la creación representa una larga época durante la cual tuvieron lugar actos específicos de la creación. Otra interpretación es que ‘yom’ significa un periodo de duración indeterminada. Este punto de vista postula que los días de Dios no están sujetos a las limitaciones temporales humanas, reconociendo que Dios, como creador del tiempo, opera fuera de nuestras limitaciones temporales. En la Biblia hay ejemplos de esta interpretación.

En 2 Pedro en el Nuevo Testamento, está escrito:

“Mas, oh amados, no ignoréis esto: que para con el Señor un día es como mil años, y mil años como un día.” (2 Pedro 3:8)

Este pasaje pretende animar a los que esperan las promesas de Dios a hacerlo con paciencia. También puede sugerir que la perspectiva de Dios sobre el tiempo difiere de la de los humanos, dando a entender que Dios puede dilatar o contraer el tiempo a Su antojo. Entendemos que el tiempo no es una cantidad fija. Según la relatividad especial, el tiempo transcurre más lentamente para el observador en movimiento que para el observador en reposo en el mismo marco inercial ( . En la relatividad general, el tiempo transcurre más lentamente en un campo gravitatorio fuerte (

. En la relatividad general, el tiempo transcurre más lentamente en un campo gravitatorio fuerte ( ).

).

Fig. 1.14. Ilustración de la dilatación del tiempo

Dios no sólo expande o contrae, sino que también detiene el tiempo. En el libro de Josué del Antiguo Testamento, está escrito:

“Y el sol se detuvo y la luna se paró, Hasta que la gente se hubo vengado de sus enemigos.” (Josué 10:13)

Este milagro ocurrió durante la batalla de Josué contra los amorreos y demuestra que Dios tiene el poder de congelar el tiempo. Además, Dios realizó un milagro aún más asombroso, según consta en 2 Reyes del Antiguo Testamento:

“Entonces el profeta Isaías clamó a Jehová; e hizo volver la sombra por los grados que había descendido en el reloj de Acaz, diez grados atrás.” (2 Reyes 20:11)

El versículo anterior refleja la respuesta de Dios a la llorosa plegaria del rey Ezequías por una vida más larga. En Su misericordia, Dios escuchó a Ezequías y le concedió 15 años adicionales. Para confirmar Su promesa, Dios realizó una señal milagrosa, haciendo que la sombra de la escalera de Acaz (reloj de sol) retrocediera diez pasos. Este milagro indica que Dios tiene el poder de invertir el tiempo, un concepto que está más allá del alcance de nuestra comprensión científica actual.

Fig. 1.15. Escalera de Ajaz (Reloj de sol)

Para los humanos, el tiempo fluye unidireccionalmente del presente al futuro, pero para Dios, como muestra la Biblia, el tiempo es una variable que Él puede controlar. Dios puede acortar, prolongar, congelar o incluso invertir el tiempo, demostrando así Su soberanía sobre las leyes naturales y poniendo de relieve el contraste entre las limitaciones humanas y Su poder infinito.

e. El Universo bien afinado

El universo finamente sintonizado expresa el hecho de que las constantes físicas fundamentales que conforman y hacen funcionar el universo están finamente torneadas con extrema precisión para que exista vida en el universo

Si la densidad del universo hubiera sido mayor que la densidad crítica, el universo se habría contraído inmediatamente después de su formación. Por el contrario, si hubiera sido menor que la densidad crítica, el universo se habría expandido demasiado rápido, impidiendo la formación de estrellas y galaxias. En cualquiera de los dos casos, no existiríamos en este mundo.

En su libro The Emperor's New Mind, Penrose utilizó la fórmula Bekenstein-Hawking de la entropía de los agujeros negros para estimar las probabilidades en el Big Bang. Calculó que la probabilidad de que el universo llegara a existir de forma que se desarrollara y sustentara la vida tal y como la conocemos es de 1 entre 10 a la potencia de 10123. Esto sugiere que nuestro universo no surgió de un azar o un proceso aleatorio, sino mediante un extraordinario ajuste fino por parte del Creador divino.

Las constantes fundamentales de la física, como la constante gravitatoria, la velocidad de la luz en el vacío, la constante de Planck, la constante de Boltzmann, la constante eléctrica, la carga elemental y la constante de estructura fina, etc., deben estar ajustadas para que exista vida en el universo. Si estas constantes fueran ligeramente diferentes, el universo sería incapaz de albergar vida.

Por ejemplo, si la constante gravitatoria fuera menor de lo que es ahora, la fuerza de la gravedad sería más débil. Esta menor atracción gravitatoria haría imposible que la materia se fusionara en estrellas, galaxias y planetas, incluida la Tierra en la que vivimos hoy. Si la constante de Planck fuera mayor de lo que es ahora, se producirían varios cambios fundamentales en el universo físico. En primer lugar, disminuiría la intensidad de la radiación solar, con lo que llegaría a la Tierra menos energía procedente del Sol. Esta reducción de la energía afectaría a muchos procesos naturales, como el clima y los patrones meteorológicos. Además, valores mayores de la constante de Planck aumentarían el tamaño de los átomos, ya que cambiaría la cuantización de los niveles de energía atómica. Este aumento debilitaría la fuerza de enlace de átomos y moléculas, haciendo que las reacciones químicas fueran menos estables. La fotosíntesis en las plantas, que depende de la absorción precisa de la energía luminosa para convertir el dióxido de carbono y el agua en glucosa, sería menos eficaz. El conjunto de los procesos bioquímicos y físicos que dependen del equilibrio actual de la mecánica cuántica se vería alterado, lo que daría lugar a un entorno radicalmente distinto y menos estable para la vida.

Entre las constantes fundamentales, la constante de estructura fina ha atraído especialmente la atención de los físicos. La constante de estructura fina, denotada por la letra griega cuantifica la fuerza de la interacción electromagnética entre partículas elementales cargadas.

cuantifica la fuerza de la interacción electromagnética entre partículas elementales cargadas.

Es una cantidad adimensional con un valor aproximado de 1/137, una cifra que ha intrigado a los físicos desde su descubrimiento. Su valor exacto es crucial para la estabilidad del universo y la existencia de la vida. Si difiriera mínimamente de su valor actual, la vida tal como la conocemos no existiría.

Si fuera mayor que 1/137, la interacción electromagnética entre las partículas sería más fuerte. Como consecuencia, los electrones estarían más ligados al núcleo, lo que reduciría el tamaño de los átomos y facilitaría la formación de elementos pesados, mientras que los elementos ligeros, como el hidrógeno, tendrían menos probabilidades de formarse. Dado que el hidrógeno es una materia prima crucial para la fusión nuclear, este cambio afectaría directamente a la supervivencia de la vida al limitar la disponibilidad del hidrógeno necesario para la producción de energía en el Sol y las estrellas. Por el contrario, si

fuera mayor que 1/137, la interacción electromagnética entre las partículas sería más fuerte. Como consecuencia, los electrones estarían más ligados al núcleo, lo que reduciría el tamaño de los átomos y facilitaría la formación de elementos pesados, mientras que los elementos ligeros, como el hidrógeno, tendrían menos probabilidades de formarse. Dado que el hidrógeno es una materia prima crucial para la fusión nuclear, este cambio afectaría directamente a la supervivencia de la vida al limitar la disponibilidad del hidrógeno necesario para la producción de energía en el Sol y las estrellas. Por el contrario, si fuera inferior a 1/137, la interacción electromagnética entre las partículas se debilitaría. Los electrones estarían menos ligados al núcleo, lo que daría lugar a átomos y moléculas inestables. Esta inestabilidad haría que los átomos y las moléculas se descompusieran más fácilmente, impidiendo la formación de moléculas complejas como el ADN y las proteínas, esenciales para la vida. Así pues, cualquier cambio significativo en la constante de estructura fina tendría profundas implicaciones para la formación de la materia y el potencial de vida en el universo.

fuera inferior a 1/137, la interacción electromagnética entre las partículas se debilitaría. Los electrones estarían menos ligados al núcleo, lo que daría lugar a átomos y moléculas inestables. Esta inestabilidad haría que los átomos y las moléculas se descompusieran más fácilmente, impidiendo la formación de moléculas complejas como el ADN y las proteínas, esenciales para la vida. Así pues, cualquier cambio significativo en la constante de estructura fina tendría profundas implicaciones para la formación de la materia y el potencial de vida en el universo.

Desconocemos el origen de su valor numérico ≈ 1/137. Dirac consideraba que el origen de

≈ 1/137. Dirac consideraba que el origen de  era ‘el problema más fundamental sin resolver de la física’. Feynman describió

era ‘el problema más fundamental sin resolver de la física’. Feynman describió como un ‘número de Dios’ o ‘número mágico’ que da forma al universo, y que nos llega sin comprenderlo. Se podría decir que la ‘mano de Dios’ escribió ese número, y ‘no sabemos cómo empujó Su lápiz’.

como un ‘número de Dios’ o ‘número mágico’ que da forma al universo, y que nos llega sin comprenderlo. Se podría decir que la ‘mano de Dios’ escribió ese número, y ‘no sabemos cómo empujó Su lápiz’.

Si reescribimos la ecuación de , puede representar varios cocientes: la velocidad de los electrones con respecto a la velocidad de la luz (es decir, la luz viaja 137 veces más rápido que los electrones), la repulsión electrostática con respecto a la energía de un solo fotón, y el radio clásico del electrón con respecto a la longitud de onda Compton reducida del electrón. Además, la relación entre la fuerza electromagnética y la fuerza gravitatoria es de 10(36), y la relación entre la fuerza electromagnética y la fuerza fuerte es de 1/137. Así pues, el valor numérico de la constante adimensional

, puede representar varios cocientes: la velocidad de los electrones con respecto a la velocidad de la luz (es decir, la luz viaja 137 veces más rápido que los electrones), la repulsión electrostática con respecto a la energía de un solo fotón, y el radio clásico del electrón con respecto a la longitud de onda Compton reducida del electrón. Además, la relación entre la fuerza electromagnética y la fuerza gravitatoria es de 10(36), y la relación entre la fuerza electromagnética y la fuerza fuerte es de 1/137. Así pues, el valor numérico de la constante adimensional podría servir como punto de referencia para las cuatro fuerzas fundamentals.

podría servir como punto de referencia para las cuatro fuerzas fundamentals.

Como se menciona en el capítulo 3, «Física de partículas y creación», toda la materia del universo (baryones) está compuesta por las partículas fundamentales descritas por el Modelo Estándar: quarks, leptones, bosones de gauge y el bosón de Higgs, que suman un total de 17. Cada partícula posee su propia masa, carga y espín únicos. Si alguna de estas propiedades fundamentales fuera ligeramente diferente, las estructuras atómicas, moleculares, biológicas y cósmicas que conocemos no existirían.

Por ejemplo, si se alterara la diferencia de masa entre los quarks up y los quarks down, se rompería el delicado equilibrio que hace que los protones sean estables y los neutrones solo ligeramente más pesados. En tal caso, no se podría formar hidrógeno ni sintetizar núcleos más pesados, lo que haría imposible la existencia de los átomos. Si la masa del electrón fuera significativamente diferente, el tamaño de los átomos y los niveles de energía cambiarían, y ya no se producirían enlaces químicos estables, lo que impediría la formación de moléculas complejas. Si se modificaran las propiedades del bosón de Higgs, se alteraría el mecanismo que da masa a todas las partículas elementales, lo que cambiaría la estructura misma del universo.

Además, si las cargas eléctricas de los protones y los electrones no fueran exactamente iguales y opuestas, los átomos neutros no podrían existir. Si las cargas de los quarks fueran diferentes, las propiedades de los protones y los neutrones cambiarían, lo que socavaría la posibilidad de que existieran los núcleos atómicos. Si los electrones no tuvieran un espín de 1/2, el principio de exclusión de Pauli no se cumpliría y los átomos no podrían mantener su estructura. Del mismo modo, si los bosones no tuvieran valores de espín enteros, se rompería el marco del campo cuántico que permite que operen fuerzas como el electromagnetismo, la fuerza fuerte y la fuerza débil. Por último, si el bosón de Higgs no fuera una partícula de espín 0, el propio mecanismo de generación de masa fallaría y las partículas no podrían existir en su forma actual.

El universo finamente ajustado refleja el asombroso equilibrio y precisión que subyacen a la existencia de todas las cosas. Desde la densidad crítica del universo, establecida con una exactitud inimaginable, hasta el cálculo de Penrose de la probabilidad infinitesimal de tales condiciones iniciales, pasando por los delicados valores de la constante gravitacional, la constante de Planck y la constante de estructura fina, cada detalle apunta a un cosmos exquisitamente calibrado para la vida. Incluso las propias partículas fundamentales —quarks, leptones, bosones y Higgs— poseen precisamente las masas, cargas y espines adecuados para permitir la existencia de átomos, moléculas, estrellas y, en última instancia, seres vivos. Tal armonía no puede atribuirse razonablemente al azar ciego.

Esta extraordinaria precisión no solo inspira asombro, sino que también nos obliga a plantearnos preguntas más profundas sobre el origen y el propósito del universo. La perfecta interacción de las leyes físicas lleva la marca de un diseño intencionado, y el concepto de la creación divina ofrece una explicación profunda y convincente. Al igual que una orquesta solo produce una hermosa sinfonía cuando todos los instrumentos están perfectamente afinados, el universo también da testimonio de la sabiduría y el poder del Creador, que ha ordenado todas las cosas con un propósito y un significado.

Si aquellos que simplemente descubrieron los principios fundamentales del universo —la gravedad, la relatividad, el principio de incertidumbre, el principio de exclusión de Pauli y el mecanismo de Higgs— son honrados como genios y galardonados con premios Nobel, ¿cuánto más grande es Dios, el Creador que no solo concibió estas leyes y principios, sino que también dio origen a todo el universo?

2. La obra maestra de Dios, la Tierra

(¿Qué tan única es la Tierra en el universo?)

La Tierra en la que vivimos ofrece una serie de condiciones muy precisas, esenciales para la supervivencia de los organismos vivos. Estas condiciones son tan precisas que a menudo sirven como extensión del universo ajustado

En este contexto, exploraremos diez condiciones especiales de la Tierra que son particularmente únicas y cruciales para sustentar la vida tal y como la conocemos. Estas condiciones ponen de relieve el extraordinario equilibrio y precisión necesarios para sustentar los organismos vivos, haciendo de nuestro planeta un oasis excepcional en la vasta extensión del universo. Al examinar estos atributos únicos, podemos apreciar mejor la intrincada interacción de los factores que permiten que la vida prospere en la Tierra.

a. Distancia adecuada al Sol

La presencia de agua líquida es crucial para la vida. Para tener agua líquida, un planeta debe orbitar dentro de una región específica alrededor de su estrella central. Si el planeta está demasiado cerca de la estrella, toda el agua hervirá, y si está demasiado lejos, toda el agua se congelará. El rango de órbitas donde el agua ni hierve ni se congela se denomina ‘zona habitable’. La zona habitable estimada en nuestro sistema solar se sitúa entre 0,95 UA y 1,15 UA (1 UA es la distancia de la Tierra al Sol). Por tanto, si la Tierra estuviera un 5% más cerca o un 15% más lejos del Sol, no estaríamos aquí.

El porcentaje de la zona habitable que ocupa el plano de la eclíptica estirado hasta Neptuno (30 UA) es sólo del 0,05%. La excentricidad de la órbita terrestre es otro factor importante que afecta al alcance de la zona habitable. Por ejemplo, si la excentricidad fuera superior a 0,5, toda el agua herviría dos veces al año cerca del perihelio y se congelaría dos veces al año cerca del afelio. Afortunadamente, la excentricidad de la Tierra es sólo de 0,017, lo que da lugar a una órbita casi circular.

Fig. 2.1. Zona habitable (verde) en el sistema solar

b. La inclinación axial adecuada

El eje de rotación de la Tierra está inclinado unos 23,5 grados. Gracias a ello, podemos tener cuatro estaciones y un clima suave. ¿Qué ocurriría si el eje de rotación no estuviera inclinado (0 grados, véase la inclinación axial de Mercurio= 0,0 grados) o estuviera completamente inclinado (90 grados, véase la inclinación axial de Urano = 82,2 grados)?

Si el eje de rotación de la Tierra no estuviera inclinado, se producirían varios cambios significativos en cuanto al clima, las estaciones y la habitabilidad. El ecuador recibiría luz solar directa y constante durante todo el año, lo que daría lugar a temperaturas eternamente cálidas. Por el contrario, los polos recibirían siempre una luz solar mínima, lo que provocaría un frío perpetuo. Este drástico contraste de temperaturas afectaría significativamente a los climas globales y a los patrones meteorológicos.

La ausencia de estaciones tendría profundas repercusiones en los ecosistemas y la agricultura. Las regiones cercanas al ecuador podrían volverse demasiado cálidas para que prosperaran muchos cultivos y organismos, mientras que las regiones polares seguirían siendo inhóspitamente frías. Las latitudes medias se convertirían en las principales zonas habitables, pero incluso estas zonas carecerían de las variaciones estacionales de las que dependen muchas plantas y animales para sus ciclos vitales y su reproducción.

Las sociedades humanas se enfrentarían a graves problemas, como la reducción de la productividad agrícola y el aumento de la presión sobre las tierras habitables. La falta de señales estacionales también podría perturbar las actividades culturales y económicas que dependen del cambio de las estaciones. En general, una Tierra sin inclinación daría lugar a un entorno menos dinámico y menos hospitalario para la vida.

Fig. 2.2. Inclinación axial de la Tierra. Sin inclinación (izquierda) e inclinación de 90 grados (derecha)

Si el eje de rotación de la Tierra se inclinara completamente 90 grados, tendría efectos profundos y dramáticos sobre el clima y el medio ambiente del planeta. En este escenario, un hemisferio experimentaría luz diurna continua durante la mitad del año, mientras que el otro estaría en constante oscuridad, y luego la situación se invertiría durante la otra mitad del año.

Cada hemisferio sufriría variaciones estacionales extremas. Durante el verano, un hemisferio recibiría luz solar constante, lo que provocaría periodos prolongados de calor intenso y condiciones potencialmente desérticas. Por el contrario, durante el invierno, el mismo hemisferio experimentaría una oscuridad continua y temperaturas bajo cero.

Los cambios drásticos de luz y temperatura perturbarían gravemente los ecosistemas. Muchas plantas y animales están adaptados al ciclo estacional actual, y cambios tan extremos amenazarían su supervivencia.

La agricultura, que depende de la previsibilidad de las estaciones, se vería muy afectada. Las regiones actualmente aptas para la agricultura podrían volverse inhabitables, lo que provocaría escasez de alimentos y la necesidad de grandes adaptaciones en las prácticas agrícolas.

En general, un eje completamente inclinado haría la Tierra mucho menos hospitalaria para la vida, creando condiciones ambientales extremas e inestables.

c. El período de rotación y el período orbital adecuados

El periodo de rotación de la Tierra es de 24 horas, con unas 12 horas de día y 12 horas de noche. Nuestro biorritmo está determinado por el periodo de rotación de la Tierra. El periodo de rotación de 24 horas proporciona un bloque de tiempo óptimo para 8 horas de trabajo, 8 horas de sueño y 8 horas de ocio. Sin embargo, no todos los planetas del sistema solar tienen un periodo de rotación óptimo. Por ejemplo, el periodo de rotación de Júpiter es de unas 10 horas, mientras que el de Venus es de 243 días.

Si el periodo de rotación de la Tierra se redujera a 10 horas, ello afectaría significativamente al medio ambiente y a la vida del planeta. Una rotación más rápida acortaría los días y las noches, provocando una rápida alternancia entre luz diurna y oscuridad. Esto podría alterar los ritmos circadianos de muchos organismos, afectando a los patrones de sueño, los comportamientos alimentarios y los ciclos de reproducción.

El aumento de la velocidad de rotación también provocaría efectos Coriolis más fuertes, intensificando los patrones meteorológicos y causando potencialmente tormentas y huracanes más severos. La rotación más rápida también podría afectar a la actividad tectónica de la Tierra. El aumento de la fuerza centrífuga podría provocar terremotos y erupciones volcánicas más frecuentes e intensas.

Por otra parte, si el periodo de rotación de la Tierra fuera de 243 días como en Venus, las consecuencias para el planeta y sus habitantes serían drásticas. Una rotación tan lenta significaría días y noches extremadamente largos, cada uno de unos 120 días.

El lado orientado hacia el Sol experimentaría un calentamiento prolongado, lo que provocaría temperaturas abrasadoras, mientras que el lado opuesto soportaría una oscuridad prolongada y un enfriamiento severo, pudiendo llegar a congelarse. Estas temperaturas extremas dificultarían la supervivencia de la mayoría de las formas de vida. Los prolongados periodos de calentamiento y enfriamiento alterarían la circulación atmosférica, lo que probablemente provocaría fenómenos meteorológicos extremos. Los huracanes, las tormentas masivas y las sequías o inundaciones prolongadas podrían llegar a ser habituales.

Los largos periodos de luz y oscuridad alterarían gravemente los ciclos vitales de plantas y animales, afectando a la fotosíntesis, la reproducción y los patrones de alimentación.

Las actividades humanas, la agricultura y las infraestructuras necesitarían una adaptación significativa para hacer frente a las duras y variables condiciones, lo que supondría un tremendo reto para la supervivencia y la vida cotidiana.

El periodo orbital de la Tierra también es importante para la supervivencia humana. El periodo orbital de la Tierra es de 365 días, con 3 meses para primavera, verano, otoño e invierno. La duración de cada estación está bien equilibrada, asegurando que ninguna estación sea demasiado corta o demasiado larga. Este equilibrio es crucial para los ciclos agrícolas, el crecimiento de las plantas, el calendario de las migraciones animales y otros procesos ecológicos.

¿Qué ocurriría si la Tierra tuviera un período orbital corto, de 88 días, similar al de Mercurio? En este escenario, cada estación duraría sólo unas 3 semanas. La mayoría de los cultivos de la Tierra requieren de 6 a 9 meses desde la siembra en primavera hasta la cosecha en otoño. Sin embargo, con estaciones que cambian cada 3 semanas, los cultivos no tendrían tiempo suficiente para madurar, lo que provocaría una grave escasez de alimentos y afectaría directamente a la supervivencia humana.

Por el contrario, ¿qué ocurre si la Tierra tiene un periodo orbital largo, como 164 años, similar al de Neptuno? Cada estación duraría unos 40 años. Los veranos prolongados provocarían olas de calor y desertización, mientras que los inviernos prolongados causarían largos periodos de frío y hielo, lo que afectaría a la agricultura y los ecosistemas. Mientras que los humanos podrían adaptarse para evitar la escasez de alimentos, los animales salvajes tendrían dificultades para encontrar comida durante un invierno de 40 años. Las duras condiciones prolongadas harían casi imposible la supervivencia de la mayoría de los animales salvajes, provocando una extinción generalizada.

d. La Tierra de tamaño adecuado

Puede que no hayas pensado en ello, pero el tamaño de la Tierra es crucial para la supervivencia de los seres humanos. El tamaño del planeta afecta a su atracción gravitatoria, que a su vez influye en todo, desde la retención de una atmósfera que sustente la vida hasta la capacidad de albergar masas de agua estables y mantener un campo magnético protector.

Si la Tierra tuviera la mitad de su tamaño actual, la gravedad se reduciría a la mitad de la actual. La gravedad reducida tendría impactos significativos y potencialmente devastadores en la capacidad del planeta para albergar vida. La gravedad reducida podría no ser lo suficientemente fuerte como para retener una atmósfera densa. Esta atmósfera más fina ofrecería menos protección contra la radiación solar dañina y los meteoroides y podría no soportar los patrones climáticos estables necesarios para la vida.

La reducción de la gravedad también afectaría a la retención de agua líquida, lo que provocaría un aumento de las tasas de evaporación y, potencialmente, una pérdida de agua superficial con el tiempo. Esto dificultaría el mantenimiento de océanos, ríos y lagos, que son cruciales para sustentar diversos ecosistemas y la civilización humana.

Además, una Tierra más pequeña tendría un campo magnético disminuido, ofreciendo menos protección contra el viento solar. Esto podría despojar a la atmósfera y exponer aún más la superficie a la dañina radiación cósmica y solar, haciendo el planeta mucho menos hospitalario para los seres humanos y otras formas de vida.

Si la Tierra tuviera el doble de su tamaño actual, los efectos sobre la gravedad y la velocidad de escape serían significativos y tendrían profundas implicaciones para la vida en el planeta. La gravedad aumentaría, haciendo que todo en la Tierra se sintiera más pesado, y la velocidad de escape también se duplicaría. Este aumento de la gravedad haría que el movimiento fuera más agotador para los seres humanos y otros organismos, lo que podría provocar un mayor estrés físico y adaptaciones con el paso del tiempo.

La combinación de una mayor gravedad y velocidad de escape también afectaría a la atmósfera. Una mayor atracción gravitatoria retendría más gases, incluidos los tóxicos como el metano y el amoníaco, similares a las atmósferas de Saturno y Júpiter. Estos gases podrían acumularse hasta niveles nocivos, creando un entorno tóxico inadecuado para la mayoría de las formas de vida.

Además, el aumento de la gravedad podría afectar a los procesos geológicos, provocando una actividad volcánica más intensa y montañas más altas. En general, una Tierra más grande, con mayor gravedad y velocidad de escape, plantearía importantes retos para la supervivencia de la vida y podría dar lugar a un entorno más hostil e inestable.

Fig. 2.3. Comparación de los tamaños de los planetas

e. La Tierra con un campo magnético fuerte

La Tierra está rodeada por un sistema de campos magnéticos conocido como magnetosfera, que protege al planeta de la dañina radiación solar y cósmica. Este escudo protector es crucial para mantener la vida en la Tierra. Para tener una magnetosfera, son esenciales dos factores: la velocidad de rotación adecuada y la existencia de un núcleo externo líquido metálico. Afortunadamente, la Tierra posee ambos. La rotación del planeta induce movimientos fluidos (convección) dentro del núcleo externo líquido, generando fuertes campos magnéticos que forman la magnetosfera.

¿Qué pasaría si no tuviéramos magnetosfera? Si la Tierra no tuviera magnetosfera, las consecuencias para los organismos vivos y la atmósfera serían graves. Sin este escudo protector, la dañina radiación solar y cósmica bombardearía el planeta, aumentando significativamente el riesgo de cáncer y mutaciones genéticas en los organismos vivos. Además, la magnetosfera ayuda a evitar la pérdida de atmósfera desviando las partículas cargadas del viento solar. Sin ella, estas partículas despojarían la atmósfera con el tiempo mediante un proceso de pulverización catódica, agotando gases esenciales como el oxígeno y el nitrógeno. Esta erosión atmosférica provocaría un adelgazamiento de la atmósfera, una reducción de la presión superficial y variaciones extremas de temperatura, lo que haría la Tierra menos hospitalaria para la vida.

Fig. 2.4. La magnetosfera de la Tierra desvía los rayos cósmicos

La intensidad del campo magnético de Marte es aproximadamente el 0,01% de la de la Tierra. Debido a la debilidad del campo magnético, la magnetosfera global no pudo formarse en Marte y, en consecuencia, la mayor parte del aire se eliminó mediante el proceso de pulverización catódica.

Las líneas de campo de la magnetosfera convergen en los polos cercanos al Ártico y al Antártico, lo que provoca un debilitamiento natural de la intensidad del campo magnético. Esto puede provocar un aumento de la exposición a la radiación solar en estas zonas. Las partículas cargadas de alta energía ionizan y excitan los átomos de la atmósfera superior y producen auroras boreales y australes.

f. La Tierra con una luna excepcionalmente grande

La Tierra tiene una Luna excepcionalmente grande en comparación con otros planetas. Entre los planetas terrestres, sólo la Tierra y Marte poseen lunas. Marte tiene dos lunas pequeñas, Fobos y Deimos, llamadas así por dos personajes gemelos de la mitología griega, con diámetros de 22,2 km y 12,6 km, respectivamente. En cambio, la Luna de la Tierra tiene un diámetro de 3.475 km, lo que la hace mucho mayor que las lunas de Marte.

La existencia de una Luna grande desempeña dos funciones importantes para la supervivencia humana: i) estabilizar el eje de rotación de la Tierra y ii) mantener los ecosistemas marinos.

Sin la Luna, las mayores fuerzas gravitatorias que actuarían sobre la Tierra procederían del Sol y de Júpiter. Como la Tierra orbita alrededor del Sol, los distintos grados de fuerza gravitatoria procedentes del Sol y de Júpiter desestabilizarían el eje de rotación de la Tierra. Si el eje de rotación de la Tierra se tambalease significativamente, experimentaríamos graves cambios climáticos, como se ha comentado en la sección anterior.

De hecho, durante los últimos 6 millones de años, Marte ha experimentado cambios sustanciales en su eje de rotación y excentricidad aproximadamente cada 150.000 años debido a la ausencia de una gran luna estabilizadora. Durante este periodo, el eje de rotación ha variado entre 15 y 45 grados, mientras que la excentricidad ha variado entre 0 y 0,11.

Fig. 2.5. Eje de rotación y cambios de excentricidad en

Las mareas oceánicas están causadas principalmente por la fuerza gravitatoria de la Luna. Las mareas proporcionan oxígeno al plancton flotante y lo distribuyen por amplias zonas, donde es consumido por pequeños peces. Las mareas también mezclan el agua dulce rica en nutrientes con el agua salada, suministrando estos nutrientes al plancton y a los peces pequeños. Sin las mareas, el agua dulce rica en nutrientes no se mezclaría con el agua salada, lo que provocaría una proliferación incontrolable de algas. Si las algas contienen toxinas, estas floraciones producirán mareas rojas o floraciones de algas nocivas (FAN), que pueden matar peces, aves marinas, mamíferos e incluso seres humanos. Incluso si las algas no son tóxicas, consumen todo el oxígeno del agua a medida que se descomponen, obstruyendo las branquias de los peces y otros seres marinos. Si no existiera la Luna, el ecosistema marino habría sido destruido hace mucho tiempo. Además, no tendríamos marisco, como langosta, gambas y sushi.

Sin embargo, incluso si la Tierra tuviera una Luna más pequeña o más grande que su tamaño actual, o si su ubicación estuviera más lejos o más cerca que su posición actual, podríamos seguir enfrentándonos a problemas similares.

Fig. 2.6. Marea roja

g. La Tierra con Júpiter como vecino

Júpiter es el mayor planeta del sistema solar, 11,2 veces más grande y 318 veces más pesado que la Tierra. La presencia de Júpiter es importante para nuestra supervivencia. La Tierra es bombardeada constantemente por meteoritos (en su mayoría asteroides destrozados y fragmentos de cometas). La frecuencia de caída de meteoritos es de un metro una vez cada hora, de unos metros una vez al día, de unos metros a 10 metros una vez al año, de unos diez metros cada década y de unos diez metros a 100 metros una vez cada siglo.

Fig. 2.7. Tamaño y frecuencia de los meteoritos que caen sobre la Tierra

Fig. 2.8. Árboles derribados por un meteorito que cayó en Tunguska

Cuando los meteoritos de menos de 10 metros entran en la atmósfera, la mayoría se queman debido a la fricción y compresión atmosféricas. Sin embargo, si su tamaño es superior a 10 metros, pueden ocurrir sucesos desastrosos. En 1908, un meteorito de unos 55 metros explotó a una altitud de entre 5 y 10 km en la región de Tunguska y aplastó unos 80 millones de árboles en un área de 2.150 km2. Este acontecimiento de Tunguska es el mayor impacto registrado en la historia de la Tierra.

Júpiter es vital porque actúa como una aspiradora cósmica, capturando meteoritos y cometas que, de otro modo, podrían impactar contra la Tierra y provocar sucesos catastróficos como el de Tunguska. Las simulaciones indican que Júpiter es unas 5.000 veces más eficaz en la captura de cometas que Earth. Una demostración notable de ello ocurrió en 1994, cuando Júpiter capturó el cometa fragmentado Shoemaker-Levy 9, que tenía un tamaño estimado de unos 1,8 km. Si este cometa hubiera chocado contra la Tierra, podría haber enviado polvo y escombros a la atmósfera, bloqueando la luz solar. Este bloqueo podría durar lo suficiente como para acabar con toda la vida vegetal, provocando la extinción de personas y animales que dependen de las plantas para sobrevivir.

Fig. 2.9. Shoemaker-Levy 9 fragmentado y su impacto en Júpiter.

h. La Tierra con tectónica de placas

La tectónica de placas es la teoría que describe el movimiento a gran escala de la litosfera terrestre, dividida en varias grandes placas tectónicas por los movimientos convectivos del manto. Esta teoría explica muchos fenómenos geológicos, como el movimiento de los continentes, la formación de montañas, los terremotos y la actividad volcánica.

Fig. 2.10. Las placas que forman la corteza terrestre

La tectónica de placas desempeña un papel crucial en diversos aspectos de los sistemas terrestres que afectan directa e indirectamente a la supervivencia humana. Uno de los aspectos más importantes de la tectónica de placas es la regulación automática del clima de la Tierra a través del ciclo del carbono.

El clima de la Tierra viene determinado principalmente por la radiación solar entrante, el albedo de la superficie terrestre y la composición de la atmósfera. Entre ellos, la radiación solar entrante es casi constante durante mucho tiempo. El albedo es una relación entre la radiación entrante y la radiación reflejada. Una fracción significativa de la radiación reflejada de la superficie de la Tierra será absorbida por las moléculas de dióxido de carbono (CO2) en la atmósfera. La radiación absorbida calienta las moléculas de CO2 y la irradia de nuevo en todas las direcciones, y aproximadamente la mitad de ella vuelve a la Tierra en forma de calor. Esta energía térmica atrapada aumenta la temperatura media global de la superficie, lo que se conoce como efecto invernadero.

El ciclo del carbono es el proceso mediante el cual el carbono se intercambia entre la atmósfera, los océanos, el suelo, los minerales, las rocas, las plantas y los animales, lo que resulta crucial para regular el clima de la Tierra. El carbono entra en la atmósfera en forma de CO2 procedente de la respiración, la combustión y las erupciones volcánicas. Las plantas absorben CO2 durante la fotosíntesis, convirtiéndolo en materia orgánica, que es consumida por los animales y devuelta a la atmósfera a través de la respiración y la descomposición. En los océanos, CO2 se disuelve y es utilizado por los organismos marinos para formar conchas de carbonato cálcico (CaCO3). Cuando estos organismos mueren, sus caparazones se acumulan en el fondo oceánico, formando rocas sedimentarias.